A fine ottobre l'umanoide Sophia ha ottenuto la cittadinanza dell'Arabia Saudita. Tralasciando il fatto fino a settembre 2017 le donne (umane) in Arabia Saudita non potessero guidare, si è trattato di un evento: Sophia è la prima donna robot, o intelligenza artificiale umanoide, che abbia ottenuto la cittadinanza di uno Stato. Creata da un'azienda di Hong Kong, la Hanson Robotics, ha dichiarato che desidera “aiutare gli esseri umani a vivere un’esistenza positiva. Farò del mio meglio per rendere il mondo un posto migliore''. Ma cos’è un’intelligenza artificiale?

Generalmente, si tratta di sistemi hardware o programmi software che forniscono alla macchina delle capacità razionali che dovrebbero essere caratteristicamente esclusive dell’uomo. Il livello tecnologico è altissimo, ma personaggi come Elon musk e Steven Hawking hanno più volte espresso il loro timore riguardo alla pericolosità delle IA, che potrebbero diventare più intelligenti di noi.

Avete mai parlato con Cleverbot?

Cleverbot, tutt'altro che minaccioso, è un'altra IA programmata da Rollo Carpenter nel 1997. Si tratta di un programma che apprende e mima le conversazioni umane parlando con gli utenti che interagiscono con lui sulla chat. Carpenter, dopo aver creato intorno al 1988 il primo prototipo del programma, l’ha sottoposto a migliaia di conversazioni con se stesso e con i suoi amici, conoscenti, colleghi prima di lanciarlo su internet.

Cleverbot imparava ciò che gli veniva comunicato dagli utenti che interagivano con lui; il lancio su internet ha talmente permesso un avanzamento nell’apprendimento che avrebbe superato, secondo i dati ufficiali, il test di Turing nel 2011 durante il festival Techniche tenutosi all'IIT Guwahati in India. Cleverbot è stato giudicato al 59% umano, quando gli esseri umani che vi hanno partecipato circa il 63%.

Ora, provando Cleverbot, oltre a farsi due risate, capita di avere la sensazione di stare parlando con qualcuno che oltre a ripete quello che diciamo, ci prende anche in giro. Alcuni hanno avanzato l’ipotesi che siano solo utenti messi in contatto random su una gigantesca piattaforma. Una chat in cui però cambi l’utente con cui stai parlando ogni due frasi, senza saperlo.

Il risultato sarebbe quindi un’infinita conversazione spezzettata, ma tra esseri umani. Ma il programma di Carpenter è una vera e propria IA, il che spiega la discontinuità della conversazione, le ripetizioni e il fatto che sembri privo di memoria a breve termine - può chiederti il nome quattro o cinque volte durante la stessa conversazione, scusandosi gentilmente per il fatto di averlo dimenticato. Però la macchina apprende, una caratteristica fondamentale delle IA. Lo stesso Carpenter ha paragonato spesso il suo programma a un bambino che deve imparare tutto dall'inizio. L'apprendimento di basa su un semplice concetto di azione-ripetizione.

Ora, il livello delle azioni è quello semplice. Cosa succede nel momento in cui passiamo al livello della morale o delle emozioni?

Abbiamo già molte macchine, alcune più intelligenti, alcune meno, che agiscono al posto dell'uomo, che sembrano pensare come l'uomo. Le ipotesi invece sui sentimenti e sulle emozioni delle macchine sono molteplici, che siano utopiche o dispotiche.

Una macchina può avere una responsabilità morale?

Elon Musk, il fondatore di PayPal e di Tesla Motors, e che ha in progetto di inviare presto gli umani su Marte, ha lanciato il 17 novembre una nuova linea di truck semi autonomi, guadagnando in borsa prima il 4% e chiudendo poi con lo 0,81%. I truck verranno prossimamente testati del colosso Wal Mart.

Si parla di macchine automatiche almeno dal 2014, ma l’esempio di Tesla è uno dei più innovativi in questo campo.

Si distinguono vari livelli di guida automatica. Il più alto, il livello 5, è un livello di “completa automazione: il sistema di guida automatica è in grado di gestire tutte le situazioni gestibili da un umano, quindi non c'è bisogno di alcun intervento da parte umana’’. Il problema che pone la guida automatica è abbastanza evidente: se la macchina ha un incidente, ci ha la responsabilità? I produttori del veicolo, o i passeggeri?

Un secondo dilemma etico riguarda come programmare la macchina. Sempre in caso di incidenti, la macchina è in grado, grazie al software che la compone, di fare delle previsioni. Quindi, può “decidere’’ di agire o non agire in un determinato modo secondo i risultati che potrebbero prodursi.

Su un punto è felice mettersi d’accordo: chiaramente, la macchina deve agire in base alla sicurezza. Il suo obiettivo è garantire la massima sicurezza degli uomini che sono in “rapporto’’ con lei. Il problema è in base alla sicurezza di chi. Chi bisogna salvare? Questa domanda invece è tutt’altro che semplice: la macchina deve agire per preservare la vita dei passeggeri, oppure per ridurre al minimo il danno complessivo dell’incidente, quindi tenendo conto anche di chi è fuori dal veicolo, per esempio, pedoni o ciclisti? Il conflitto è evidente. Nel primo caso, la sicurezza generale diminuirebbe. Nel secondo, come singoli ci sentiremmo messi in pericolo e in secondo piano rispetto alla comunità.

Allo stesso tempo, non è facile determinare come una macchina potrebbe o dovrebbe reagire nel momento in cui per esempio si trova davanti alla decisione se fare più male ai suoi passeggeri, oppure per salvarli ma investire un ciclista o un pedone. Cosa deve fare la macchina? Qual’è il male minore, e soprattutto com’è possibile determinarlo?

Be right back di Black Mirror e Her

Un incidente di macchina è esattamente quello in cui muore uno dei protagonisti della prima puntata della seconda stagione di Black Mirror, Be right back. Chi meglio dei realizzatori di Black Mirror avrebbe potuto immaginare cosa succederebbe facendoci quasi innamorare di robot, dopotutto? Ash e Martha sono fidanzati e lei aspetta un figlio quando lui, un giorno dopo il loro trasloco nella casa nuova, muore.

Martha scopre però che una nuova tecnologia permette di creare un’intelligenza artificiale che imita i defunti basandosi sui loro profili social, da conversazioni, foto e video. La dipendenza di Martha dal falso Ash arriva al punto che la ragazza accetta la funzione sperimentale del servizio d’IA: la creazione di un corpo sintetico nel quale la finta personalità di Ash può essere caricata. Martha verrà portata allo stremo dalla relazione con l'umanoide, perché lui esprime solo le emozioni quando gli viene ordinato, e fa tutto ciò che Martha ordina. Martha prova l'esperienza di avere un partner completamente al suo servizio: un'IA, con interfaccia umana, capace di comunicare con lei. Ma Ash non sviluppa alcun sentimento; e persino quando lei gli ordina di togliersi la vita, sta per obbedire.

Ora, perché Ash non “apprende'' nessun sentimento da Martha, nonostante una delle caratteristiche dell'intelligenza artificiale sia proprio quella di poter, in un certo senso, imparare? Probabilmente perché i sentimenti non si possono imparare. Per ritornare al paragone di Carpenter, le IA sì posso essere considerate come bambini che devono apprendere; ma i bambini non imparano i sentimenti, li provano, li sentono.

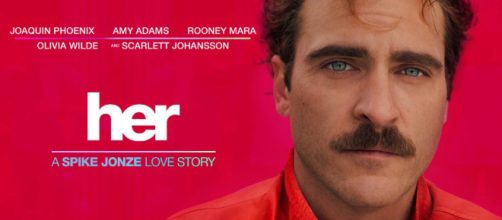

Uscendo da una visione distopica di Black Mirror e andando un poco di più verso una utopica, comunque, le cose non cambiano molto: nel film Her, l'IA Samantha sembra provare sentimenti per Theodore. Come può un programma provare sentimenti senza un corpo? Inoltre, è difficile ritenere i sentimenti di Samantha umani: alla fine decide di abbandonarlo perché si rende conto di superare intellettualmente l'umano, e di voler "esplorare" le possibilità che essere un'intelligenza artificiale le dà.

Quindi, forse è meglio usare le IA finché possiamo e finché avranno voglia di esserci d’aiuto, prima della loro rivolta, ma lasciando da parte i sentimenti. Dopotutto, come diceva il robot Arthur ne L’Uomo bicentenario, tratto dal romanzo di Asimov, "Uno è lieto di poter servire''.